AI Chat GPT Stable Diffusion イベントレポ インディーゲーム キースイッチ デスク周り 推し活 水族館

Category:

OpenAI社の開発した会話型AI「Chat GPT」。流暢な文を生成でき、執筆やプログラミングなどにも対応可能ということで、一躍注目を集めていますね。

ただ、内容の正確性には課題もあり、「それらしいことを回答するけど嘘も多い」とも言われています。

この記事では、『Chat GPTに科学についての専門的な内容を聞いた際、どのくらい正しい返答が返ってくるのか』を検証して、研究やレポートのお供としてのChat GPTの使い方を探ります。

Chat GPTは、2022年11月末に公開されたOpenAI社の大規模言語モデル。日本語も対応しており、チャット形式なので非エンジニアでも簡単に使えるサービスです。

Chat GPTに使われているのが、RLHF (Reinforcement Learning from Human Feedback) という手法の強化学習。これは人間のフィードバックを言語モデルに反映させていく手法です。

人間のフィードバックを挟むことで、「人間にとって好ましい、自然な出力」ができるように設計されているということですね。

かなり幅広い出力が可能で、流暢な言葉を返してくれます。

一方、不正確な情報を提供する可能性もあるため注意が必要。回答を鵜呑みにするのではなく、内容をよく確認することが重要と言われています。

早速、Chat GPTを使ってみましょう。

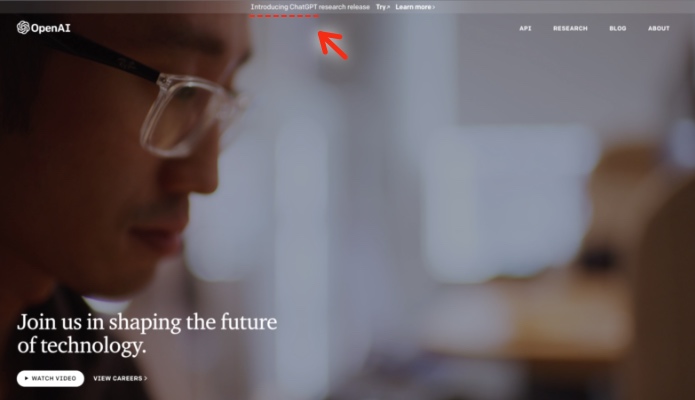

OpenAIのページから、「Chat GPT」を起動します。

アカウントの作成を求められるので、メールアドレスの登録と電話番号認証をしてアカウントを作成。システムにログインできたら、ChatGPTの利用規約と開示情報に目を通せば準備は完了です。

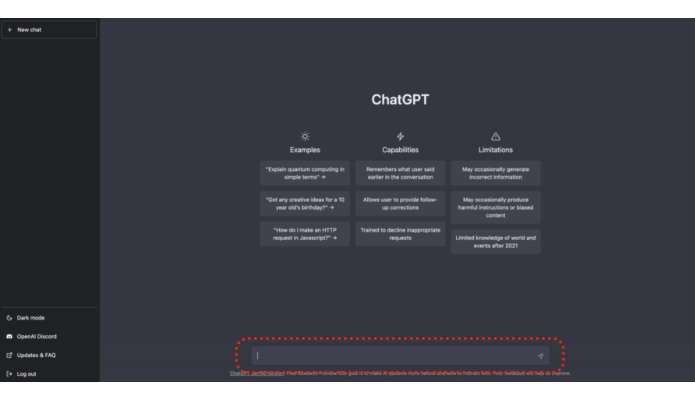

ページ下部のウィンドウに質問を入力すれば、チャット形式でAIからの回答が返ってきます。

Chat GPTは、専門的な内容をどのくらい正確に回答できるのか。

検証のため、「核酸科学」という分野のニッチなテーマ

についての説明を聞いてみることにしました。

RNAワールド仮説について先に説明すると、

生命の起源についての仮説の一つで、『原始地球で最初にRNAが誕生し、そこからDNAやタンパク質などが作られ、生物の形になっていったのではないか』という説(1986年に発表)

です。

RNAからDNA やタンパク質が作られるには対応する酵素が必要ですが、酵素としても働けるRNA:リボザイムが発見されたことにより「生命の起源はRNAだった可能性がある」というロマンある説が生まれました。

(2019年に隕石からリボースが発見されたこともあり、原始の地球にも同様にリボースが存在して、そこからRNAが作られたのでは?と近年また盛り上がっていました)

そんな科学用語について、Chat GPTはどのくらい正確な情報を答えてくれるのでしょうか。楽しみです。

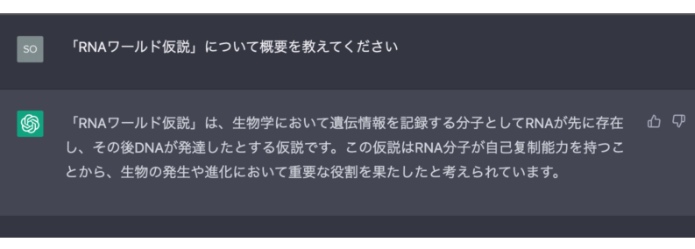

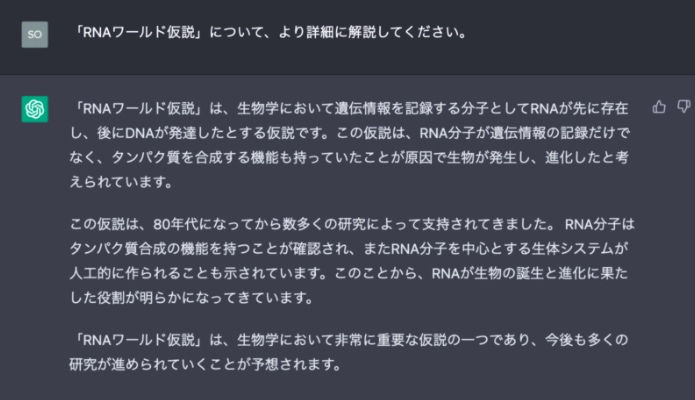

早速Chat GPTに「RNAワールド仮設」について質問してみます。

……間違ったことは言ってはいないのですが、「RNAが先に存在し、その後DNAが発達した」というだけではかなり説明不足です。なぜか簡体字が混ざっているのも気になりますね。

もう少し詳細に聞いてみることにします。

説明不足だった先ほどと変わって、マトモな回答が返ってきました。「RNAワールド仮説」の概要としては及第点でしょう。

ただ、第2パラグラフは言い過ぎな部分も。

確かに、RNAによる人工的な生体システムについての研究もありますが、限定的な条件にとどまっており「作られることも示されている」というのは語弊があります。さらに言うと、「RNAが生物の誕生と進化に果たした役割が明らかになってきています」は明らかに過言です。

重箱の隅を突くような指摘ですが、科学は客観的な線引きが重要なのでコレはNGですね……。

もしかしたら、関連文献やニュース系記事のロマン溢れる表現などに引っ張られているのかもしれません。

科学についてのChat GPTの回答は『おおむね正しく、文章も綺麗だけれど、科学的には細部が正確ではないことがある』。

気になったのが、専門家以外で話題になりにくいニッチ用語でこの結果だったこと。

一般からの誤解が多い分野では、その分AIが変な内容を参照して、間違った回答が増える可能性があります。

ただ、これだけ流暢な文章でそれらしい回答が返ってくることは素直に感動を覚えますね。

ついでに、「RNAワールド仮説」の参考文献を挙げてもらいました。

それぞれの論文を検索したところ、「タイトルだけは精度が高いが、その他の情報は間違いが多い」と言う驚きの結果に。

もしかしたら、Chat GPTは「論文タイトル・掲載誌は自然言語としてある程度取り扱えるけれど、その後に続く人名や数字(ページ数など)と紐付けるのは苦手」なのかもしれません。

今回の結果をみる限り「おおむね正しく、文章も綺麗だけど、科学的には微妙に正確じゃない」「文献の年代・ページ情報の扱いは苦手」という最大のネックがあるので、出力した内容そのままを研究やレポートに活用するのは難しいです。

個人的には、次のような使い方がいいのかな、と思います。

結局、細かい内容の精査が必要なので、普段の文献調査と大きくは変わらないだろうな……。というのが素直な感想ですね。

ただ、参考文献リストのタイトルはある程度信用できそうなので、キーになる研究を探す手間は省力化できそう。

AIに全てを頼るのではなく、手間のかかる作業の代替として、上手く活用したいですね。

コメント